RoPHa: Robuste Perzeption für die interaktive Unterstützung älterer Nutzer bei Handhabungsaufgaben im häuslichen Umfeld

Reiternavigation

Referenz

In Kürze

Das Forschungsprojekt RoPHa hatte zum Ziel, die Fähigkeiten von Servicerobotern weiterzuentwickeln, damit sie alltägliche Manipulationsaufgaben sicher und interaktiv ausführen können. Die entwickelten Funktionen wurden auf dem Serviceroboter Care-O-bot® 4 implementiert, um ihn in die Lage zu versetzen, Essen z.B. durch Schneiden oder Bestreuen vorzubereiten und zum Mund des Nutzers zu führen.

Im Detail

Service- und Assistenzroboter, die ältere oder hilfsbedürftige Menschen unterstützen, bieten das Potenzial, die Eigenständigkeit der Betroffenen zu erhöhen und damit dem demographischen Wandel entgegenzuwirken. Roboter sind insbesondere dann eine echte Hilfe, wenn sie in Alltagssituationen aktiv helfen können.

Das Forschungsprojekt »Robuste Perzeption für die interaktive Unterstützung älterer Nutzer bei Handhabungsaufgaben im häuslichen Umfeld« (RoPHa) zielte darauf ab, die Fähigkeiten interaktiver Assistenzroboter so zu erweitern, dass sie alltägliche Manipulationsaufgaben in komplexen und dynamischen Umgebungen sicher ausführen können. Insbesondere musste die Roboterwahrnehmung robust gegenüber unsicheren und ungenauen Informationen werden.

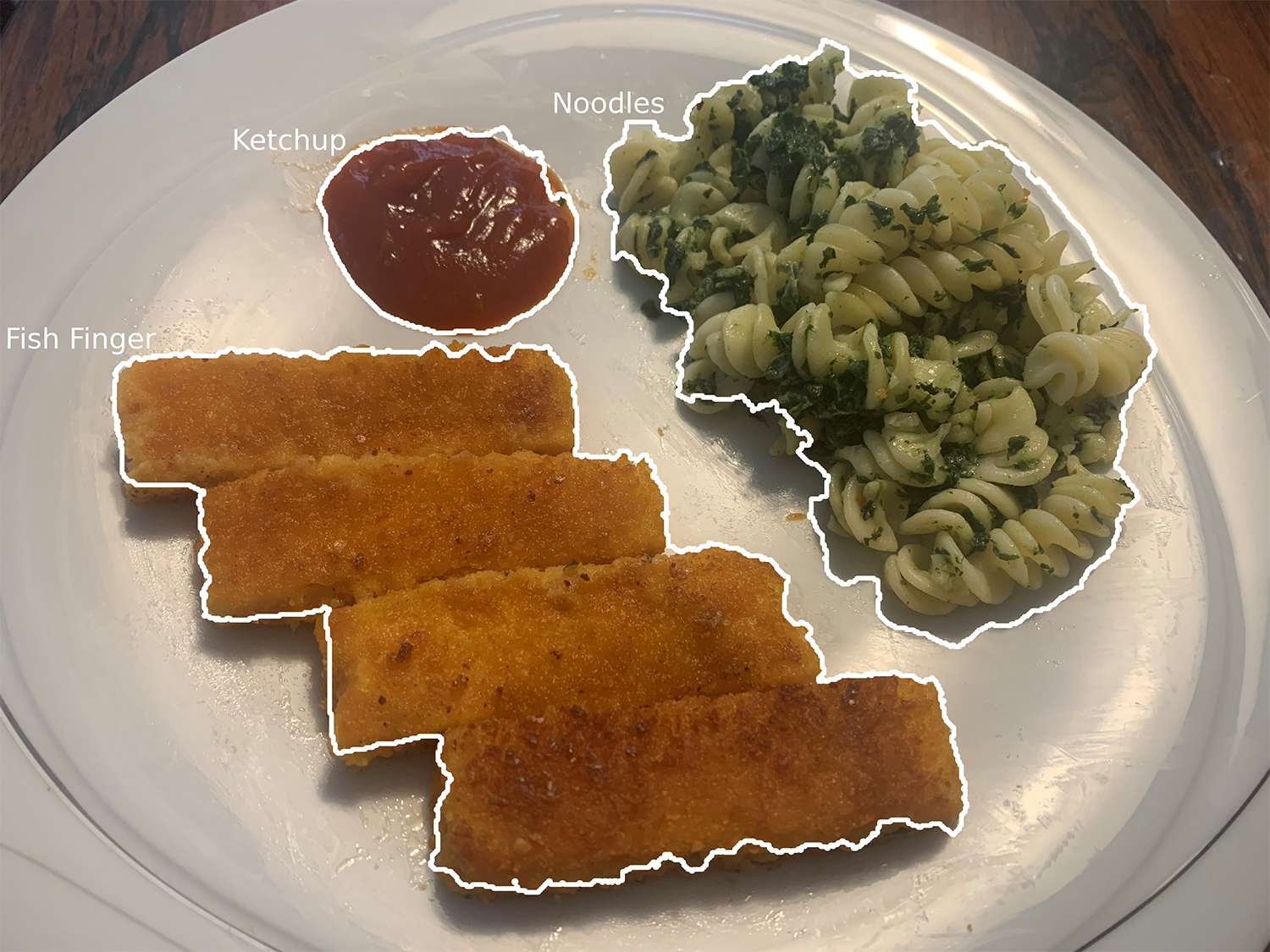

Die entwickelten Technologien wurden auf dem Serviceroboter Care-O-bot® 4 implementiert. Als Use Case wählten die Projektpartner gemeinsam mit Experten aus der Pflege die mundgerechte Bereitstellung von Nahrung, da die Unterstützung dieser Aufgabe den Pflegealltag signifikant erleichtern könnte. Auf Basis der Projektergebnisse ist der Roboter in der Lage, Essen z.B. durch Schneiden oder Bestreuen vorzubereiten und zum Mund des Nutzers zu führen. Möglich machen dies die bildverarbeitenden Algorithmen des Fraunhofer IPA, die auch Methoden des maschinellen Lernens nutzen. Damit kann der Roboter die Speisen auf dem Teller erkennen und lokalisieren und entsprechend diesen Informationen handhaben. Die technische Machbarkeit und der Nutzen der implementierten Unterstützungsfunktionen wurde in Tests mit Endnutzervertretern erfolgreich evaluiert.

Die entstandenen Softwarelösungen können abseits des Pflegekontexts beispielsweise auch für den Einsatz in Großküchen oder für autonomere Büfetts eingesetzt werden.

Projektpartner

- Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA (Koordination)

- Roboception GmbH

- ArtiMinds Robotics GmbH

- Universität Bremen, Institut für Künstliche Intelligenz

Einbindung als Unterauftragnehmer:

- Stiftung Evangelische Altenheimat

- Interaktionswerk/Glückler, Graef, Gronbach GbR

Projektübersicht

| Projektlaufzeit | 01/07/2017 - 30/06/2020 |

| Projektvolumen | 2,60 Mio. EUR (davon 80% Förderanteil durch BMBF) |

Video

Robuste Perzeption für die interaktive Unterstützung bei Handhabungsaufgaben (RoPHa)

Datenschutz und Datenverarbeitung

Wir setzen zum Einbinden von Videos den Anbieter YouTube ein. Wie die meisten Websites verwendet YouTube Cookies, um Informationen über die Besucher ihrer Internetseite zu sammeln. Wenn Sie das Video starten, könnte dies Datenverarbeitungsvorgänge auslösen. Darauf haben wir keinen Einfluss. Weitere Informationen über Datenschutz bei YouTube finden Sie in deren Datenschutzerklärung unter: https://policies.google.com/privacyDas Video zeigt die Ergebnisse des Forschungsprojekts RoPHa. Darin entwickelten die Projektpartner Technologien für zwei Einsatzszenarien mit dem Serviceroboter Care-O-bot 4, um hilfsbedürftige Menschen beim Essen zu unterstützen. Zum einen wurden Technologien für die Hilfe bei der Nahrungsaufnahme entwickelt. Dafür wählt der Nutzer das gewünschte Essen auf einem Tablet-PC aus. Der Roboter erkennt das Essen auf dem Tisch vor ihm, nimmt eine Portion auf einen Löffel und führt diesen in Richtung des Mundes. Zum anderen wurden Softwarekomponenten für vorbereitende Aufgaben entwickelt. Hierfür erkennt und lokalisiert Care-O-bot 4 wiederum Essen und Zutaten auf dem Tisch und kann beispielsweise eine Waffel bestreuen und diese dann zweihändig schneiden. Da die Software- und Steuerungskomponenten modular aufgebaut sind, können sie auch kurzfristig für vielfältige Einsatzszenarien mit anderer Hardware genutzt werden.