ASARob: Aufmerksamkeitssensitiver Assistenzroboter

Reiternavigation

Referenzprojekt

In Kürze

Ziel des Forschungsprojekts »Aufmerksamkeitssensitiver Assistenzroboter« (ASARob) war, neue Fertigkeiten für interaktive Assistenzroboter – insbesondere neue Bildverarbeitungslösungen – zu entwickeln, sodass diese den Aufmerksamkeitszustand ihres Gegenübers erfassen und bei Bedarf durch ihr Verhalten auch beeinflussen und lenken können. Die Umsetzung erfolgte auf dem Assistenzroboter Care-O-bot® 4, indem der Roboter eine Person sicher und aufmerksam durch ein öffentliches Gebäude zum Ziel führt.

Im Detail

Wenn Assistenzroboter wie der Care-O-bot® 4 dem Menschen im Alltag hilfreich zur Seite stehen sollen, müssen sie grundlegende Fähigkeiten der zwischenmenschlichen Interaktion beherrschen. Um angenehm und effektiv zu unterstützen, ist eine fehlerrobuste und erwartungskonforme Interaktion des Roboters mit dem Menschen essenziell. Dafür wurden im Projekt »Aufmerksamkeitssensitiver Assistenzroboter« (ASARob) Funktionen entwickelt, die es einem Roboter ermöglichen, zu erkennen, worauf sich die Aufmerksamkeit des Nutzers richtet und welche Absicht er verfolgt.

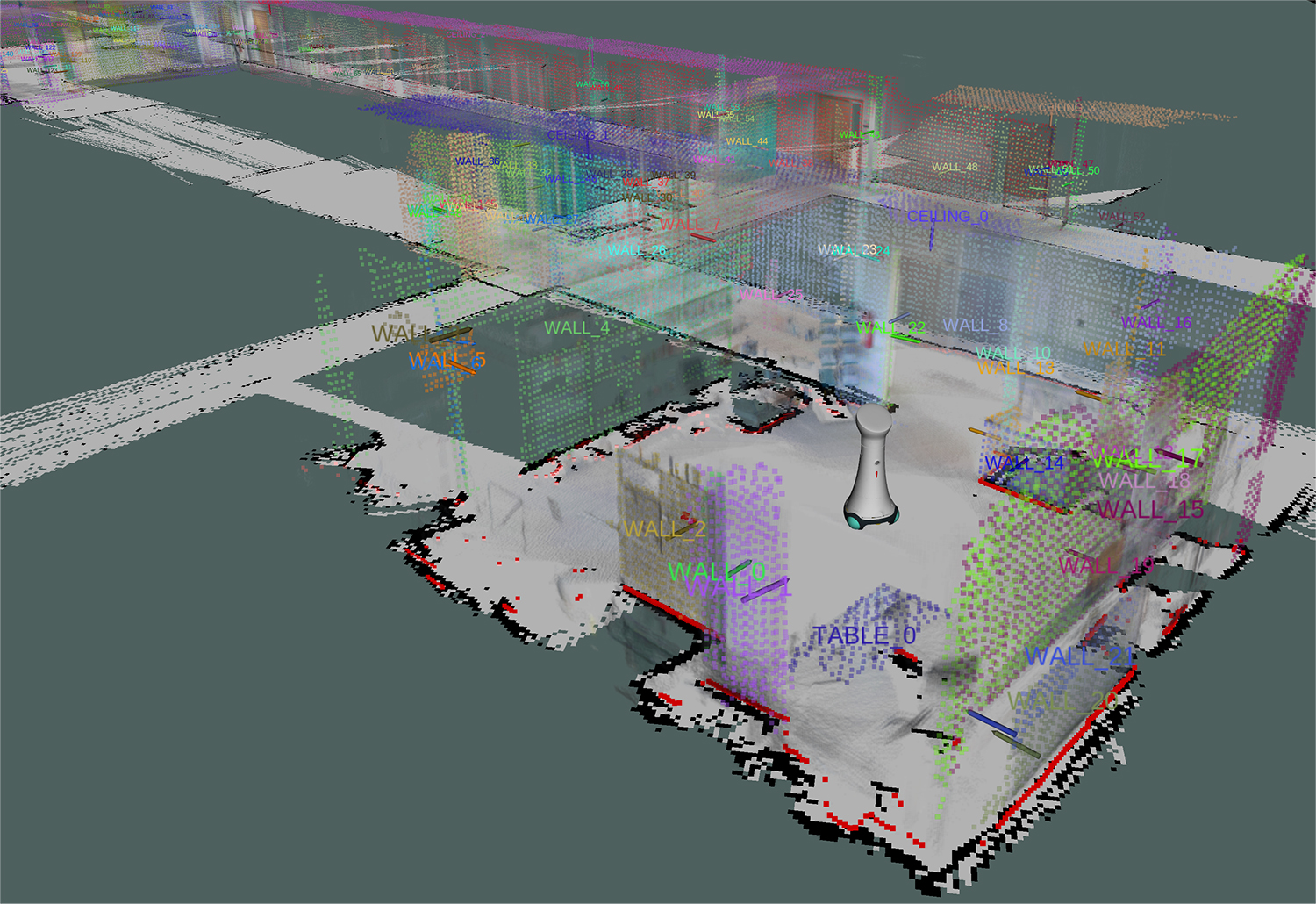

Um diese Fähigkeiten zu unterstützen, hat das Fraunhofer IPA im Projekt ein Umgebungsmodell entwickelt, welches auch Semantiken beinhaltet. Diese verbessern das Verständnis über die Umgebungsinformation, die als 3D-Punktewolke vorliegt, und erkennen erfasste Objekte beispielsweise als Stuhl, Tisch oder Pflanze. Möglich machen dies neue Softwaremodule, die geometrische Formen erkennen und klassifizieren und entsprechende Raumstrukturen daraus ableiten.

Die entwickelten Technologien ergänzen das Angebot zur Personen- und Aktivitätenerkennung, das am IPA bereits vorhanden war. Ein Roboter kann eine Szene nun ganzheitlich verstehen. Die Softwarekomponenten sind einzeln oder als gebündelte Lösung für vielfältige Anwendungen einsatzbereit.

Video

Datenschutz und Datenverarbeitung

Wir setzen zum Einbinden von Videos den Anbieter YouTube ein. Wie die meisten Websites verwendet YouTube Cookies, um Informationen über die Besucher ihrer Internetseite zu sammeln. Wenn Sie das Video starten, könnte dies Datenverarbeitungsvorgänge auslösen. Darauf haben wir keinen Einfluss. Weitere Informationen über Datenschutz bei YouTube finden Sie in deren Datenschutzerklärung unter: https://policies.google.com/privacyDas Video zeigt die Ergebnisse des Projekts ASARob. Darin haben Forscher neue Fertigkeiten für interaktive Assistenzroboter entwickelt. Diese können insbesondere den Aufmerksamkeitszustand ihres Gegenübers erfassen und bei Bedarf durch Verhalten und Interaktion beeinflussen. Insbesondere wurden Methoden entwickelt, die es dem Roboter ermöglichen, über unterschiedliche Kommunikationskanäle (textliche, auditive, sprachliche, räumliche und visuelle) die Aktivitäten einer Person zu erkennen und worauf sich deren Aufmerksamkeit aktuell richtet. Außerdem wurden Verfahren entwickelt, mit deren Hilfe der Roboter die Aufmerksamkeit über dieselben Modalitäten lenken kann. Die technologische Umsetzung der Aufmerksamkeitskomponenten erfolgt auf dem Assistenzroboter Care-O-bot 4 (https://www.care-o-bot.de). Als mögliches Einsatzfeld der neu entwickelten Funktionen wurde die Führung von Patienten im Krankenhaus betrachtet.