Zentrum für Kognitive Robotik

Das Zentrum für Kognitive Robotik erweitert die Forschungs- und Innovationskompetenz des Fraunhofer IPA durch den Einsatz der Künstlichen Intelligenz (KI) in den Forschungsfeldern der Robotik und Mensch-Maschine-Interaktion.

Die Robotik als physische, in realen Anwendungen umgesetzte KI kombiniert mit datenarmen KI-Methoden wird genutzt, um die Leistungsfähigkeit und Autonomie von Robotersystemen im Sinne einer » Automatisierung der Automatisierung « zu steigern sowie komplexe Aufgaben zu beherrschen. Damit Mensch und Maschine erfolgreich zusammenarbeiten, entstehen Lösungen, mit denen Technik für jedermann bedienbar wird. Sowohl Industrie- als auch Serviceroboter erhalten kognitive Fähigkeiten, um ihr Umfeld wahrzunehmen und daraus Handlungen abzuleiten. Sie » verstehen «, wie eine Aufgabe zu lösen ist oder lernen, indem sie das menschliche Vorbild imitieren.

Das Zentrum unterstützt Unternehmen dabei, die Potenziale der Service- und Industrierobotik voll auszuschöpfen. Es leistet Beiträge, um neue Applikationsfelder auch außerhalb der Produktion zu erschließen und Antworten auf Megatrends wie Demografischer Wandel, Individualisierung, Nachhaltigkeit und Digitalisierung zu finden. Es entstehen Technologieentwicklungen, die den Einstieg in die Robotik sowie die Weiterentwicklung und Qualitätsverbesserung bestehender Anwendungen erleichtern, vereinfachen und wirtschaftlicher gestalten. Konkret bietet das Zentrum für Kognitive Robotik Technologien an, die:

- den Aufwand in der Roboterprogrammierung reduzieren,

- die Verfügbarkeit von Roboteranlagen erhöhen,

- die Einrichtprozesse für z. B. Greif- und Bearbeitungsprozesse automatisieren,

- die Bedienbarkeit von Servicerobotern erleichtern

- und die Autonomie von Robotern erhöhen

Über das Partnerprojekt KI-Fortschrittszentrum greifen die IPA-Wissenschaftler zudem auf Kompetenzen des CyberValley in der KI-Grundlagenforschung zurück.

Unsere Kompetenzen

Selbstlernende CPR

Anwendung & Nutzen

Im internationalen Wettbewerb müssen Unternehmen auch bei sinkenden Stückzahlen wirtschaftlich produzieren können. Roboter wären hierfür eine Schlüsseltechnologie. Ihre Programmierung ist allerdings bislang aufwendig und an Expertenwissen gebunden, sodass sich der Robotereinsatz erst bei größeren Stückzahlen wirtschaftlich lohnt.

Ziel der » Selbstlernenden Cyberphysischen Robotersysteme « ist, die Roboterprogrammierung mithilfe von Maschinellem Lernen deutlich zu vereinfachen und in großen Teilen zu automatisieren. Der Roboter erkundet autonom seine Umgebung und kann seine Verhaltensweise selbstständig ableiten und optimieren. Dieser Lernprozess findet in einer physikalischen Simulationsumgebung statt, in der die reale Produktionsumgebung als digitaler Zwilling modelliert wird. So wird die reale Anlage nicht blockiert und die Inbetriebnahme des realen Roboters geht schneller.

Technologie

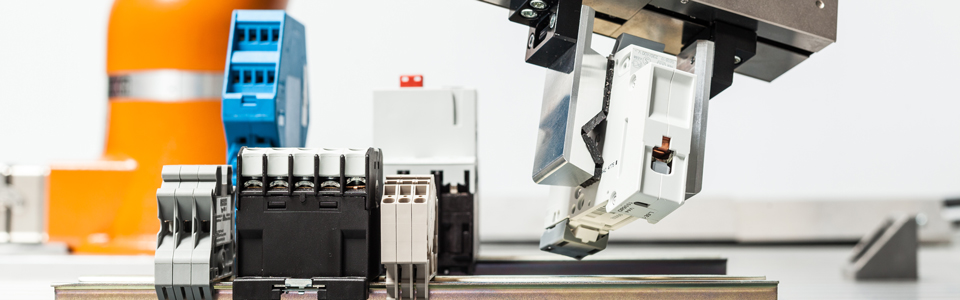

Im Demonstrator wird hierfür eine integrierte Physiksimulation umgesetzt, die die realitätsnahe Simulation von Montageprozessen mittels Schnappverbindungen ermöglicht. Ein Machine-Learning-Framework leitet als Programmiergerüst den Roboter in der Simulation an. Das Expertenwissen über die Roboterprogrammierung und die auszuführende Montageoperation wird mittels vordefinierter Roboterskills und einer Erweiterung der Simulationsumgebung als detailliertes Fügemodell bereitgestellt.

Die entwickelte Technologie wird in zwei praxisorientierten Stufen – dem Fügen von Objekten in Führungen (Peg-in-Hole-Prozess) und dem Fügen von Schaltschrankklemmen – von der Simulation in die Realität transferiert und evaluiert, um abschließend erste Anwendungsfälle für die Schaltschrankmontage umsetzen zu können.

Selbstoptimierende CPR

Anwendung & Nutzen

Der Automatisierungsbedarf in der Schweißtechnik ist hoch und der Mangel an Schweißfachkräften erhöht die Nachfrage nach Schweißrobotern weiter. Gleichzeitig ist der wirtschaftliche Einsatz bei kleinen Losgrößen oft noch nicht möglich. Das Fraunhofer IPA entwickelt deshalb verschiedene Komponenten, um den Einsatz von Schweißrobotik zu vereinfachen und rentabler zu gestalten. Hierzu gehört, die Sensorikansätze und Algorithmen zur kollisionsfreien Schweißbahnplanung zu verbessern und zu erweitern.

Technologie

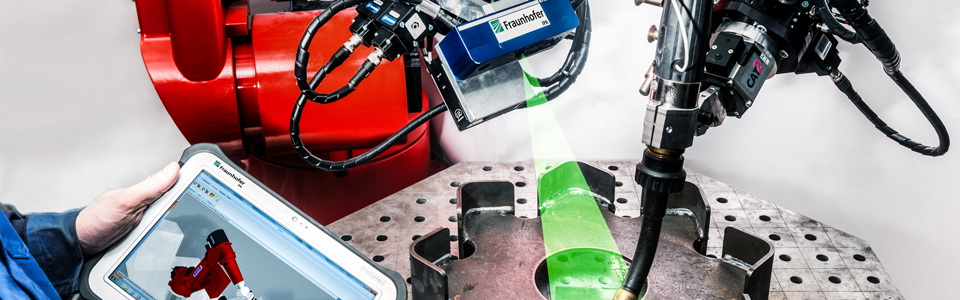

Neben dem Einsatz von 3D-Sensorik, um Bauteile lokalisieren und Abweichungen im Zusammenbau erkennen zu können, wird in diesem Demonstrator ein 2D-Linienscanner-Add-On für kollaborative Schweißroboter (» Cobots «) entwickelt. Dieses Add-On ermöglicht mit günstigen Cobots wie beispielsweise dem UR10 die Schweißnaht stark vereinfacht zu programmieren. Dafür wird der Schweißroboter zunächst in die Startposition an der Naht gebracht. Anschließend folgt der Roboter der Schweißnaht, dank des vorgeschalteten Linienscanners, automatisch. Im Gegensatz zu existierenden 2D-Sensorik-Lösungen beschränkt sich die Technologie nicht nur auf eine Online-Anpassung der programmierten Schweißnaht oder eine nachlaufende Qualitätskontrolle, sondern automatisiert das Programmieren der Schweißnaht an sich. Das aufwendige, manuelle Teach-In entfällt und Abweichungen in der Naht werden automatisch berücksichtigt.

Selbstheilende CPR

Anwendung & Nutzen

Durch den zunehmenden Einsatz von Robotern in der Industrie gibt es einen ständigen Bedarf für Roboter, die ihre Aufgaben auch in herausfordernden Situationen erfolgreich erfüllen können. Sie sind jedoch für verschiedene Fehlerarten anfällig. Bezogen auf die Programmierung einer Anwendung haben die Programmierer derzeit alle möglichen Fehler zu berücksichtigen, um ein verlässliches Programm zu erzeugen. Diese Fehlerquellen erhöhen sowohl Zeitaufwand als auch die Komplexität des Programms. Unbehandelte oder unerwartete Fehler können allerdings nicht automatisch erkannt werden. Die Lösung für die Fehlerbeseitigung ist das sichere Herunterfahren der Steuerung, doch das erhöht möglicherweise die Ausfallzeit.

Technologie

Deshalb schaffen wir einen neuen Ansatz für die effektive Assistenz bei der automatischen Erkennung und Behandlung von Fehlern. Im Zentrum für Kognitive Robotik werden wir hauptsächlich zwei Funktionalitäten anbieten. Zum einen der fehlertolerante Programmablauf für eine einfache Roboteranwendung, um einige aus der Erfahrung in der Produktion bekannte Fehler zu behandeln. Zusätzlich wird eine Pipeline zur Fehlerbehandlung (Fehlerüberwachung, -diagnose und -behebung) angeboten, um unbekannten Fehlern zu begegnen. In dieser Fehlerbehandlungspipeline werden KI-basierte Algorithmen die Fehler automatisch erkennen und den Robotern helfen, sich von einem Fehlerzustand zu erholen.

Objektperzeption

Anwendung & Nutzen

Der Einsatz mobiler Serviceroboter in dynamischen und unstrukturierten Alltagsumgebungen erfordert entsprechend flexible Perzeptionsfähigkeiten. Jedoch sind aktuelle Perzeptionslösungen für die Robotik meist hochoptimierte Spezialsysteme für einen bestimmten Aufgabenkontext. Damit sind diese in vielen Fällen nicht allgemeingültig und nur schwer auf andere Anwendungen übertragbar. Eine weitere Herausforderung betrifft die Effizienz der Algorithmen, die erforderlich ist, um diese auf mobilen Systemen mit eingeschränkten Berechnungsressourcen einzusetzen. Der Demonstrator » Objektperzeption « zeigt, wie diese aktuellen Hürden für den Einsatz von Perzeptionslösungen gelöst werden können.

Technologie

Im Rahmen des Demonstrators » Objektperzeption « wird ein generisches, universelles Objekterkennungssystem entwickelt, das insbesondere auch den Einsatz mobiler Serviceroboter in unstrukturierten Alltagsumgebungen unterstützt. Dabei wird auf die Ergebnisse umfassender Vorarbeiten des Fraunhofer IPA in der 2D- und 3D-Bildverarbeitung und Objekterkennung für die Robotik zurückgegriffen. Wichtige Aspekte, die die Flexibilität vorhandener Lösungen steigern werden, sind dabei die sog. » flexible Multimodalität « und das » semantische Verstehen « der zu erkennenden Objekte.

Unter flexibler Multimodalität wird zum einen die Verarbeitung und Zusammenführung verschiedener Sensormodalitäten wie z. B. von Farbkameras und 3D-Sensoren verstanden – je nach deren Verfügbarkeit und szenenabhängiger Datenqualität. Zum anderen findet eine Auswertung unterschiedlicher Erkennungsaspekte wie Form, Farbe, Textur, Aufschriften, Logos, etc. statt. Damit ist es möglich, Objekte sowohl in Produktions- als auch in Alltagsumgebungen generisch und robust zu beschreiben.

Mithilfe des semantischen Verstehens von Objekten können bspw. Funktionen von Objektteilen (sog. » Affordances «) abgebildet werden. Zudem werden den Objekten symbolisch verständliche Form-/Farb-/Texturdeskriptoren zugewiesen. Diese unterstützen z. B. die natürlichsprachliche Interaktion und Kommunikation der Erkennungsentscheidungen durch das Robotersystem.

In der Folge sind damit sowohl Identifizierung und Lageschätzung spezifischer, vorher bekannter Objekte möglich (z. B. für das Kommissionieren) als auch die Erkennung von Objektklassen oder die abstrakte Erkennung noch nie gesehener Gegenstände (» Was könnte das ungefähr sein? «). Insbesondere ist dadurch eine Objekterkennung ohne die bisher herrschenden Einschränkungen auf texturierte Objekte, einfache Objektgeometrien oder die Nutzung von CAD-Daten möglich.

Das generische, universelle Objekterkennungssystem mit robusten und bewährten Komponenten kann somit einfach an unterschiedliche Anwendungen angepasst werden. Dies ermöglicht zukünftig zudem kognitiven, mobilen Servicerobotern, sicher in unstrukturierten Umgebungen mit Menschen zu agieren.

Greifplanung

Anwendung & Nutzen

Die automatisierte Handhabung und Platzierung von Objekten ist in den meisten Branchen zu einer wichtigen Anwendung geworden. Eine vollständig automatisierte Roboterlösung für Pick-and-Place-Systeme ist das Gebot der Stunde in der Industrie. Es gibt jedoch einige Herausforderungen bei automatisierten Pick-and-Place-Systemen aufgrund der großen Variation von Werkstücken und deren Handhabung durch verschiedene Greifertypen. Darüber hinaus ist für das Einrichten eines neuen Werkstücks für ein Pick-and-Place-System nicht nur viel Zeit, sondern auch Expertenwissen über die Software erforderlich. Die Industrie wünscht sich eine Software, die auch von einem nicht fachkundigen Benutzer bedient werden kann und die für die Einrichtung eines neuen Werkstücks wenig Zeit benötigt.

Das Fraunhofer IPA berücksichtigt all diese Probleme und bietet eine kompakte Lösung in Form einer bp3™-Software mit Maschinellem Lernen an. Die in der Software enthaltenen Techniken des Maschinellen Lernens helfen dem Benutzer, die Software einfach zu bedienen, ohne dass zusätzliche Kenntnisse oder Expertise erforderlich sind. Die neue Technologie erleichtert dem Benutzer nicht nur die Bedienung, sondern verbessert auch die Robustheit des Pick-and-Place-Systems. Diese Software gibt dem Benutzer auch Flexibilität, indem sie sowohl modellbasierte als auch modellfreie Greiftechniken zur Verfügung stellt.

Technologie

Im Rahmen des Demonstrators wollen wir die genannten Herausforderungen durch die Anwendung moderner Techniken des Maschinellen Lernens angehen. Diese Techniken machen die Software intelligenter und robuster. Der Demonstrator konzentriert sich in erster Linie darauf, eine Lösung für die Automatisierung der Parameterabstimmung für die Objekterkennung und die Automatisierung der Greifpunktgenerierung zu erhalten. Diese Technologien tragen dazu bei, die Software auch für einen Nicht-Experten benutzerfreundlicher zu machen. Um der Software mehr Flexibilität zu verleihen, wird eine modellfreie Greiftechnik entwickelt. Diese Technik hilft dem Benutzer, die Software in jenen Szenarien anzuwenden, in denen kein geometrisches Modell des Werkstücks zur Verfügung steht.

Die neu entwickelten Technologien in der Griff-in-die-Kiste-Software des Fraunhofer IPA haben gegenüber den Vorgängerversionen größere Vorteile gezeigt. Die Software befindet sich in der Testphase, um die Stabilität für ihre industrielle Freigabe zu gewährleisten. Die neue Softwareversion wird nicht nur die Hemmungen der industriellen Nutzer reduzieren, die bisher noch nicht in den roboterbasierten Griff-in-die-Kiste investiert haben, sondern durch ihre erhöhte Effizienz auch neue Marktinteressen erzielen.

Kollisionsvermeidende Manipulation

Anwendung & Nutzen

Mobile Serviceroboter mit Manipulationsfähigkeiten finden allmählich Zugang zu unserer alltäglichen Umgebung, indem sie zum Beispiel Hol- und Trageaufgaben ausführen. Um die Sicherheit der Menschen in der Nähe zu gewährleisten und Umweltschäden zu vermeiden, müssen die Roboter in der Lage sein, statische und dynamische Hindernisse zu erkennen und sich darin zurechtzufinden. Insbesondere im Vergleich zu Industrierobotern mit festen Aufgaben und Sicherheitsausrüstung müssen interaktive Robotermanipulatoren flexibel in ihren Bewegungen sein, um mit der Dynamik ihrer Umgebung zurechtzukommen. Das Ziel des Demonstrators » Kollisionsfreie Manipulation « ist die Entwicklung einer neuen reaktiven Steuerung für Robotermanipulatoren, die deren kollisionsfreien Betrieb in unstrukturierten und unübersichtlichen Umgebungen ermöglicht.

Technologie

Die neue Lösung, die den Betrieb von Robotermanipulatoren in gemeinsamen Mensch-Roboter-Arbeitsräumen unterstützt, wird auf der Methode der Nichtlinearen Modellvorhersagekontrolle (NMPC) basieren. Sie ermöglicht die Durchführung kollaborativer Aufgaben bei gleichzeitiger Vermeidung von Kollisionen mit jeglichen statischen oder dynamischen Hindernissen wie Menschen. Dabei wird eine reibungslose Bewegung des Roboters aufrechterhalten - ohne abrupte Stopps oder Änderungen der Bewegungsrichtung.

Die reaktive Steuerung wird in bestehende Lösungen zur Bewegungsplanung und Hinderniserkennung integriert. Der Bewegungsplaner erzeugt eine sanfte und kontinuierliche Raumkurve vom Start bis zur gewünschten Zielposition des Roboters. Die Trajektorie besteht aus mehreren Wegpunkten entlang der gewünschten Bewegungsrichtung. Das Modul Hinderniserkennung nimmt Kollisionsobjekte on-the-fly, z. B. mittels 3D-Sensoren, wahr und liefert Informationen über deren geometrische Lage und Dimension. Der Algorithmus versucht ferner, die Bewegung von Hindernissen vorherzusagen und potenzielle Kollisionen im Voraus zu erkennen und zu vermeiden.

Der Bewegungssteuerungsalgorithmus verfolgt kontinuierlich Echtzeitinformationen über die Trajektorie und die (vorhergesagte) Position des Hindernisses. Eine exponentielle Kostenfunktion wird verwendet, um Kollisionen zuverlässig zu vermeiden. Konkret minimiert der Controller diesen Kostenwert durch reaktive Bewegungen des Roboterarms (» Abstoßungskraft « durch Hindernisse). Gleichzeitig werden Abweichungen von der ursprünglichen Trajektorie auf ein Minimum reduziert, indem Schlüsselparameter wie » Konturfehler « und » Schleppfehler « des Roboters (» Anziehungskraft « durch gewünschte Trajektorie) reduziert werden.

Das entwickelte Verfahren ist generisch, so dass es leicht sowohl an verschiedene Arten von Roboterarmen als auch für redundante Manipulatoren oder die vollständige kinematische Kette eines mobilen Kopierroboters angepasst werden kann.

Imitation Learning

Anwendung & Nutzen

In der Montage werden Produkte häufig noch manuell gefertigt, aber das Interesse und der Bedarf an einer roboterbasierten Ausführung steigen. Gründe für den geringen Automatisierungsgrad sind bislang die hohen Investitionskosten und die lange Setupzeit für einen Roboter. Aktuell müssen hochspezialisierte Experten den manuellen Prozess erst mühsam erlernen, um diesen im Anschluss in ein Roboterprogramm umzusetzen. Das hohe motorische Wissen der Werker über den Prozess, z. B mit welchen Kräften ein Snap-Fit einrastet, geht dabei verloren. Ziel dieses Demonstrators ist es daher, die Erstellung des Roboterprogramms automatisiert zu unterstützen und so den Einrichtprozess zu beschleunigen.

Technologie

Hierfür setzt unsere Technologie direkt beim Experten für den motorischen Prozess an mit dem Ziel, die Zeit des Roboterprogrammierers effektiv zu nutzen. Dazu nehmen wir die Trajektorien und Interaktionskräfte auf, die während der manuellen Montage auftreten, und nutzen diese als Leitlinie, um ein Roboterprogramm zu erstellen.

Durch die Nutzung dieser Trajektorien und Kraftdaten lassen sich auch motorisch komplexe Programme automatisch realisieren, wie z. B. Drücken und Bewegen in unterschiedliche Richtungen. Unterteilt in sinnvolle Einzelskills (z.B. mehrere komplexe Snap-Fits), können die erzeugten, komplexen Programme auch einzeln wiederverwendet werden, wenn sich die Geometrie des Objekts ändert oder andere Varianten automatisiert werden sollen.

Da die Programme aus mehreren manuellen Montagevorgängen destilliert werden, können diese als eine sichere Leitlinie genutzt werden, um das Programm anschließend automatisch mithilfe von Maschinellem Lernen zu optimieren.

Einblick in das Projekt

Datenschutz und Datenverarbeitung

Wir setzen zum Einbinden von Videos den Anbieter YouTube ein. Wie die meisten Websites verwendet YouTube Cookies, um Informationen über die Besucher ihrer Internetseite zu sammeln. Wenn Sie das Video starten, könnte dies Datenverarbeitungsvorgänge auslösen. Darauf haben wir keinen Einfluss. Weitere Informationen über Datenschutz bei YouTube finden Sie in deren Datenschutzerklärung unter: https://policies.google.com/privacyProgrammieren von Robotern durch Demonstrieren von kraftgeregelten Montagevorgängen